DeepNude: la polémica aplicación que se utilizaba para desnudar mujeres

Durante los últimos días hemos visto en crecimiento el término deepfake, una técnica empleada para utilizar las caras de personajes famosos en situaciones de toda índole, incluso para modificar sus palabras gracias a tecnologías como el deep learning. No obstante, hace unas semanas salió a la vista una nueva aplicación que utilizaba la misma técnica para desnudar a mujeres a través de algoritmos de inteligencia artificial.

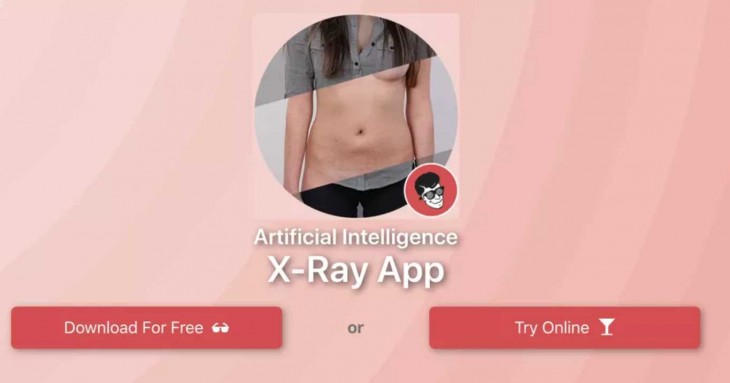

El software, que se hacía llamar DeepNude, utilizaba las redes neuronales para reconocer las partes de la imagen que se sitúan en el lugar de la ropa, y así sustituirla con la información recopilada a partir de miles de imágenes de mujeres desnudas descargadas de internet. Tras ser publicada y divulgada por Motherboard, sus creadores decidieron ponerle precio por la descarga, que oscilaba entre los 50 y 100 dólares.

El mal uso de las tecnologías

El programa, que se promocionaba como una aplicación de rayos X que funcionaba a base de inteligencia artificial, estaba desarrollado para computadores. Proporcionaba imágenes a baja resolución con una marca de agua que indicaba la palabra «FAKE» en rojo, aunque esta se podía recortar fácilmente.

Es muy obvio que la aplicación no desnudaba realmente a las mujeres, sino que más bien realizaba el trabajo de sustitución de una prenda con otros que se asimilaban a la persona. Aún así, no dejaba de generar pánico entre aquellas víctimas que veían cómo sus fotos eran divulgadas a través de las redes sociales sin su consentimiento.

A diferencia de los deepfakes, que llevan horas, conocimientos técnicos y el uso de programas complejos, este tipo de apps son relativamente inmediatas, reduciendo su funcionamiento a clicks.

DeepNude utilizaba una implementación de software de pix2pix, un desarrollo de la Universidad de Berkeley que utiliza redes generativas antagónicas (GANs) entrenadas con más de 10.000 imágenes, según afirma el mismo desarrollador, que se hace llamar Alberto.

Eliminada horas después de recaudar el dinero suficiente

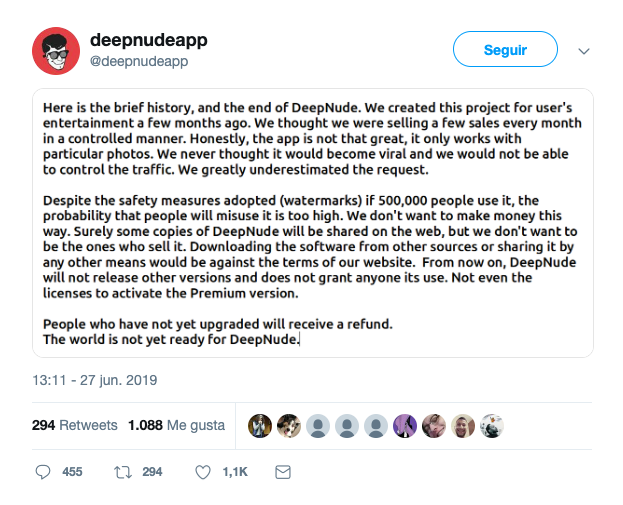

El motivo por el que parece su único desarrollador decidió eliminar la aplicación, es que con la gran repercusión y el gran número de descargar iniciales, que cifra en medio millón, las «probabilidades de uso indebido son demasiado altas» y «no quieren hacer dinero de esa manera».

A través de un mensaje en su cuenta de Twitter, el encargado del desarrollo de la aplicación apunta a que las «medidas de seguridad» que recordemos, era la marca de agua, «no serían suficientes si tanta gente la usa».

DeepNude afirma que no publicará ninguna otra versión y «no consiente el uso de la misma a nadie». Por curiosidad, el desarrollador termina el comunicado afirmando que «el mundo todavía no está listo para DeepNude».

Varios medios apuntan a que el verdadero motivo que llevó al cierre de la aplicación fue el temor del desarrollador a verse sumergido en los temas legales que una aplicación de este estilo puede tener.

Sin duda, la publicación de este software abrió nuevamente el debate en torno al uso de la tecnología en contra de las mujeres, utilizando imágenes sin su consentimiento que puedan llevar a una distribución con malas intenciones. Sin que realmente la persona sepa de la existencia de las imágenes.

En países como Estados Unidos ya existe un proyecto de ley que intenta «defender a cada persona de apariencias falsas». Sin embargo, no parece ser suficiente, pues algunos expertos apuntan a la responsabilidad individual de la ciudadanía de evitar el consumo de material pornográfico obtenido de manera ilegal.

Relacionados